IV. Les techniques de base de la SEO : optimisation interne▲

IV-A. Introduction▲

Une page web est composée de contenu (images, textes), et de balises qui indiquent au navigateur (comme Internet Explorer ou Firefox) la manière dont doit être mis en forme ce contenu. Il est possible d'utiliser ces balises pour améliorer le positionnement d'un site ; c'est même la première chose à faire pour espérer placer une page de manière correcte sur un moteur de recherche.

IV-B. Les balises <meta>▲

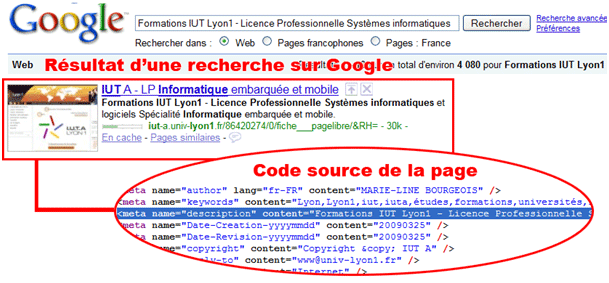

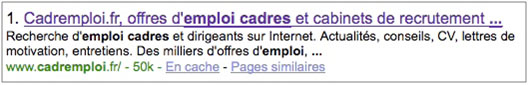

Chaque page web est identifiée par des balises <meta>. Ces balises attribuent un titre, une description, une liste de mots clefs… à la page, autant d'éléments qui seront utilisés par les moteurs de recherche pour analyser votre page. Par exemple, dans l'illustration suivante, on remarque bien que la balise <meta> " description " est utilisée par Google pour décrire la page :

Il convient donc de renseigner au mieux ces balises pour faciliter au maximum la tâche aux moteurs de recherche lors de l'indexation du contenu.

IV-B-1. Remarque▲

On considère généralement aujourd'hui que la balise <meta> de mots clefs (keywords) n'a quasiment plus aucun impact. En effet, les différents abus réalisés par de nombreux sites aux alentours des années 2000 ont poussé les moteurs de recherche à diminuer le poids de cette balise dans leurs algorithmes.

IV-C. L'URL▲

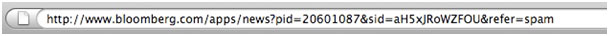

L'URL est l'adresse de la page. Elle correspond à ce que l'on tape dans la barre d'adresse pour accéder à la page (par exemple, l'url de Google France est " http://www.google.fr "). Contrairement à ce que l'on pourrait penser en observant l'arborescence des pages, une url ne correspond pas à une adresse physique : on peut naviguer dans une url comme on navigue dans des dossiers (en allant dans le dossier enfant, etc.), mais il est possible de redéfinir des url, de les retravailler : c'est l'URL Rewriting. L'objectif de cette réécriture sera alors de créer une URL optimisée pour les moteurs de recherche, c'est-à-dire une url :

- Qui contient maximum 5 paramètres (idéalement, 0) (8) dans la mesure du possible

- Qui contient les mots clefs de la page concernée

Les seuls séparateurs de mots reconnus par l'ensemble des moteurs de recherche sont le tiret (-) et le slash(/).

IV-D. Mots en gras▲

Les mots en gras (entre balises <strong> et <b>, et non par mise en forme CSS) sont valorisés par les moteurs de recherche, et considérés comme plus importants que le reste du texte. Les expressions les plus importantes doivent donc être mises entre des balises de mise en exergue du texte, dans la mesure du raisonnable.

Les mots en gras sont un des aspects importants de la SEO.

IV-E. Le titre▲

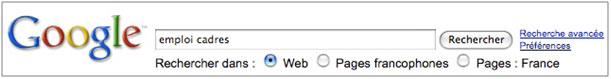

Le titre qui apparaît dans la barre de titre de la fenêtre est défini par la balise <title>. C'est l'élément généralement considéré aujourd'hui comme déterminant pour le bon positionnement d'une page. Il faut donc que les mots clefs importants, sur lesquels on souhaite être bien positionné sur Google, soient présents dans le <title> de la page.

Bien sûr, il ne suffit pas de juxtaposer les mots clefs pour être bien positionné. Généralement, on considère qu'un <title> doit avoir une taille maximale de 200 caractères. De plus, les deux ou trois premiers mots ont plus de poids pour Google. Il faut donc passer l'expression la plus importante en premier dans le titre.

Pour avoir du poids dans l'algorithme des moteurs de recherche, chaque <title> doit être unique sur le site (chaque page doit avoir son propre titre).

IV-F. Bots, Robots.txt et Sitemap.xml▲

Il est possible d'aider les moteurs de recherche dans leur indexation. En effet, ces derniers utilisent des robots (Bots), comme le GoogleBot, qui parcourent l'ensemble d'internet en suivant tous les liens qu'ils trouvent sur leur passage (" Crawling "). Certains de ces bots suivent les instructions contenues dans des fichiers d'instruction, placés à la racine du site :

IV-F-1. Le fichier robots.txt▲

Le fichier robots.txt contient permet de préciser au Bot si la page doit être indexée (répertoriée) ou non. Cela peut-être utile pour cacher certaines pages sur Internet. Malheureusement, seul Google semble respecter ces instructions. Dans la pratique, interdire l'indexation d'une page (ou d'un dossier) aux bots à l'aide d'un robots.txt est illusoire.

IV-F-2. Le fichier sitemap.xml▲

Ce fichier contient la liste des pages d'un site web. Cela permet d'éviter que des pages orphelines (des pages auxquelles on ne peut pas accéder directement en cliquant sur un lien, mais uniquement en tapant l'URL dans la barre d'adresse) ne soient pas indexées par les moteurs de recherche. Il ne doit pas y avoir de lien mort sur un site (" page 404 "). En effet, Google pénalise largement les sites sur lesquels il existe des erreurs de ce type. (9)

IV-G. Synthèse▲

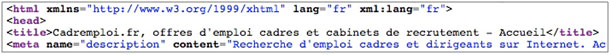

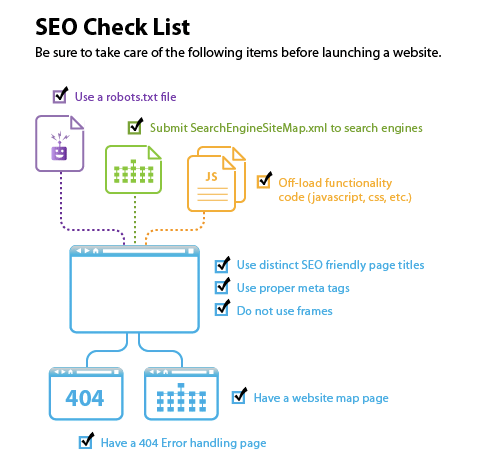

Pour simplifier la compréhension de ces techniques de base de la SEO d'optimisation technique, nous pouvons consulter l'illustration suivante, qui synthétise cette section :

Source : SEO CHECK LIST - Elliance